Искусственный интеллект в тестировании: машинное обучение и языковые модели для автоматизации QA-процессов

Роль ИИ в тестировании

Искусственный интеллект стал неотъемлемой частью современной разработки: он ассистирует в написании кода, помогает в поиске дефектов и оптимизирует процесс релизов. Для команд качества важно эффективно интегрировать эти технологии в существующие процессы.

В этой статье разбираем, как использовать машинное обучение для автоматизации рутинных задач, таких как устранение дубликатов и приоритизация регрессионных тестов. Мы рассмотрим, как ИИ помогает не только ускорять процессы, но и повышать стабильность релизов, освобождая время команды для более важных «человеческих» задач.

Проблемы роста объёма тестовой базы

Количество тест‑кейсов стабильно растёт в каждом спринте. Как только база превышает две‑три тысячи записей, ручное сопровождение превращается в узкое место:

Обновлять устаревшие шаги сложно — команда тратит часы, а релиз откладывается. Например, изменение одного поля в форме может потребовать обновления 50-100 тест-кейсов, на что уходит 3-4 часа ручной работы одного специалиста.

Находить дубликаты трудно — отчёты «шумят» повторяющимися ошибками, и критичный баг может уйти в продакшен.

Приоритизировать регрессионные проверки почти невозможно — рискованные сценарии тонут среди менее важных.

В результате может снизиться скорость поставки кода и доверие бизнеса к QA‑процессу.

Языковые модели (LLM) — новый уровень автоматизации тестирования ПО

Рост количества тест-кейсов и усложнение функциональности программных систем создают значительную нагрузку на процессы верификации и сопровождения. Ручное тестирование остаётся незаменимым для задач, требующих экспертного анализа, творческого мышления и глубокого знания предметной области — таких как исследовательское тестирование или оценка UX. При этом современные достижения в области искусственного интеллекта (ИИ), включая языковые модели ChatGPT, Deepseek и Grok, позволяют автоматизировать повторяющиеся и рутинные операции, высвобождая время тестировщиков для более сложных аналитических задач.

Что такое ИИ, машинное обучение и LLM в контексте QA

Искусственный интеллект (Artificial Intelligence, AI) = общее обозначение алгоритмов, которые воспроизводят человеческие когнитивные способности: обнаруживают закономерности, принимают решения и обучаются на опыте. В тестировании AI помогает автоматизировать повторяемые операции, находить скрытые дефекты и прогнозировать риски релиза.

Машинное обучение (Machine Learning, ML) = раздел AI, в котором модель строится на основании исторических данных. В QA это, например, система, которая сравнивает список изменённых файлов с результатами прошлых запусков и оценивает вероятность падения каждого теста до того, как начнётся прогон.

Большие языковые модели (Large Language Models, LLM) = разновидность ML‑моделей, обученных на огромных корпусах текстов. Они принимают запрос на естественном языке и возвращают согласованный текст или структуру данных. Для инженера‑тестировщика LLM выступает «универсальным ассистентом»: по формулировке требования генерирует последовательность шагов, а при необходимости — шаблон автоматизированного теста или краткое резюме лога.

Почему эти технологии важны в QA

Оптимизация регрессионного тестирования. ML-модели анализируют изменения в коде и историю запусков, выявляя наиболее критичные тесты для приоритетного выполнения.

Расширенное тестовое покрытие. LLM помогают в создании тестовых сценариев, предлагая варианты проверок на основе анализа требований и документации. Это особенно полезно при поиске граничных случаев и негативных сценариев.

Автоматизация рутинных задач. Автоматическая генерация и актуализация тестов, создание документации и тикетов существенно сокращает объем ручной работы.

Стандартизация процессов. Использование ИИ-инструментов обеспечивает единообразие в оформлении тестов, документации и отчетов, повышая качество тестовой базы.

📌 Дополнительные материалы в блоге ТестОпс

Подробнее о структуре тест‑кейса — в гайде «Что такое тест‑кейс».

Принципы работы современных языковых моделей (LLM)

Языковые модели анализируют текст, учитывая контекст и связи между словами, что позволяет им понимать смысл и генерировать релевантные ответы. Качество их работы зависит от размера модели и объёма данных, на которых она обучена. В контексте тестирования это означает, что модель может:

Понимать требования — анализировать документацию и выделять ключевые сценарии для тестирования.

Генерировать тест-кейсы — создавать разнообразные проверки, включая граничные случаи.

Адаптироваться к контексту — учитывать специфику проекта и предыдущий опыт тестирования.

Безопасность данных и локальное использование LLM

Конфиденциальность является критически важным аспектом при внедрении ИИ-инструментов в процессы тестирования программного обеспечения. Чтобы минимизировать риски утечки данных, всё чаще применяются локально развёрнутые языковые модели. Одним из инструментов для их запуска является Ollama — облегчённый фреймворк, позволяющий загружать модели семейства LLaMA, Mistral, Deepseek и других и использовать их непосредственно на рабочей станции без обращения к облачным сервисам. Такой подход обеспечивает полный контроль над вычислительной средой и данными, что особенно важно при работе с чувствительной или внутренней информацией.

Требования к ресурсам для локального запуска LLM

Токен = минимальная единица текста, которую обрабатывает модель (обычно это часть слова или знак препинания). Например, слово «тестирование» может состоять из 2-3 токенов

| Конфигурация | CPU | GPU | RAM | Пример скорости генерации* |

|---|---|---|---|---|

| Минимальная | 4 ядра | без CUDA | 8 ГБ | ≈ 2 токена/с |

| Рекомендуемая | 8 ядер | RTX 3060 6‑8 ГБ | 16 ГБ | ≈ 5 токенов/с |

| Производительная | 12+ ядер | RTX 3080 10‑12 ГБ | 32 ГБ | 10+ токенов/с |

* Скорость приведена для модели объёмом ~7 млрд параметров.

Практическая польза. Такая конфигурационная матрица помогает подобрать оптимальное оборудование под задачи команды и запускать LLM локально — прямо на стандартных рабочих станциях без выделенных серверов или кластеров. Благодаря этому сокращается цикл разработки, снижаются затраты на инфраструктуру и сохраняется полный контроль над данными.

Важным технологическим решением является квантование — это как «сжатие» модели, похожее на то, как мы сжимаем фотографии или видео, чтобы они занимали меньше места, но сохраняли приемлемое качество. Квантование — метод оптимизации моделей, который уменьшает требования к памяти и ускоряет их работу. При правильной настройке и выборе параметров квантования возможно достичь хорошего баланса между производительностью и качеством работы модели. Благодаря этому даже большие языковые модели могут эффективно работать на обычных ноутбуках с видеокартами на 6–8 ГБ памяти, что делает их доступными для повседневного использования в задачах генерации тестов, анализа логов и проверки сценариев. Такой подход обеспечивает независимость от внешних API и позволяет выполнять ключевые задачи автономно, с высокой скоростью и гибкостью. Он идеально подходит для команд, которым требуется быстрая проверка гипотез, изоляция конфиденциальной среды или офлайн-режим работы.

Почему командам тестирования стоит внедрять ИИ

Ручное тестирование по‑прежнему определяет, удобно ли пользоваться продуктом и соответствует ли он ожиданиям бизнеса. Проблема в масштабе: после каждого изменения кода нужно прогнать тысячи сценариев, актуализировать автотесты и задокументировать результаты. Именно в этих точках языковые модели — ChatGPT, Deepseek, Grok и другие — берут на себя механическую часть работы, а инженеры получают время для анализа нестандартных случаев.

Чем именно LLM упрощают жизнь QA‑специалиста

| Боль процесса | Как проявляется на практике | Что делает LLM (большая языковая модель) |

|---|---|---|

| Долгая обратная связь | Полный регресс выполняется часами, поэтому релиз «ждёт тесты» | Приём Test‑Impact Analysis: модель смотрит, какие файлы менялись, и собирает мини‑набор самых «опасных» тестов — запускаем сотни вместо тысяч |

| Нестабильные (flaky) тесты | Тесты, которые при одних и тех же условиях могут как пройти, так и упасть из-за внешних факторов (например, изменения в DOM или REST-ответе) | Ассистент анализирует причины нестабильности, сравнивает тест с текущим состоянием системы и предлагает надёжные исправления |

| Много ручной рутины | Нужно описать новый тест, создать задачу, проставить приоритет и метки в Jira | Модель по ключевым словам из требования собирает черновик тест‑кейса и шаблон тикета; инженеру остаётся проверить и нажать Save |

После такой автоматизации тестировщик тратит время на то, что машине пока недоступно: поиск необычных пользовательских путей, обсуждение неоднозначных требований, оценку визуального и UX‑поведения.

Технические принципы реализации ИИ-решений

Оценка риска. Лёгкая ML‑модель изучает историю багов и список последних изменений, чтобы понять, где вероятнее всего появится дефект.

Генерация и правки. LLM формулирует текст — описание теста, шаги, комментарии — и предлагает патч‑файл с изменениями, который можно принять прямо из IDE.

Такая связка превращает ИИ в надёжного помощника: машина делает объёмную «черновую» работу, а человек принимает финальные решения там, где нужна экспертиза.

📌 Читайте также

Что такое пирамида тестирования — как эффективно выстраивать тестирование и распределять тесты.

Инструменты с интеграцией LLM

Помимо описанных выше преимуществ, современные решения с интеграцией языковых моделей позволяют значительно ускорить ежедневные задачи QA-специалистов:

| Тип инструмента | Функциональность ИИ | Польза для QA-инженеров |

|---|---|---|

| IDE‑плагин Cursor (AI‑плагин) | Генерация кода, автоматический рефакторинг, поиск по коду | Сокращение времени на рутину и повышение продуктивности |

| Zero Steps | Преобразование текстовых сценариев в автотесты с AI-распознаванием UI-элементов | Быстрое создание автотестов для типовых сценариев с последующей валидацией человеком |

| AI-поиск по документации | Быстрый поиск спецификаций и инструкций | Эффективный онбординг и изучение новой функциональности |

Важно отметить, что инструменты с ИИ — это помощники, которые требуют экспертной проверки полученных результатов.

📌 Полезные статьи

Что такое TMS и зачем она нужна команде тестирования — как системы управления тестированием (Test Management System) помогают организовать процессы, повысить прозрачность и эффективность работы QA-команды.

AI-агенты — следующий уровень автоматизации

AI-агенты представляют собой автоматизированные процессы, способные самостоятельно выполнять последовательности действий, используя встроенные инструменты и API. Современные платформы, такие как N8N, позволяют настроить работу агента по следующему алгоритму:

Триггер. Активация происходит при событии, например при падении теста в CI.

Сбор данных. Агент извлекает информацию из логов — идентификатор теста, стек‑трейс, сведения об окружении.

Создание задачи. На основе собранных данных агент формирует тикет в Jira (или другой системе), автоматически заполняет поля, прикрепляет логи и назначает ответственных.

Ссылка на отчёт/Dashboard. В завершение agent добавляет ссылку на отчёт или дашборд, чтобы команда могла оперативно приступить к анализу.

Такая цепочка ускоряет реакцию на сбои, снимает ручную нагрузку и делает обратную связь полностью прозрачной.

Инструментальная база для каждого этапа работы агента

Автоматический рефакторинг кода — добавляет аннотации, комментарии и приводит тесты к единому стилю.

Формирование отчётов — собирает результаты запуска и структурирует их в Allure‑ или HTML‑формате (например, Allure Report для CI‑пайплайна).

Интеграция с системами задач — автоматически создаёт или обновляет тикеты в Jira, прикрепляя логи и назначая ответственных.

Отправка уведомлений — публикует ссылку на отчёт в Slack или e‑mail, завершая цикл обратной связи.

💡 Пример: при падении UI-теста в CI агент автоматически создаёт задачу в Jira с приоритетом на основе истории падений, прикрепляет скриншот ошибки, трейс и видеозапись сессии, а также оповещает команду в Slack — весь процесс занимает меньше минуты и не требует участия человека.

📌Читайте также

Что такое тестовые данные и зачем их готовить — разбираем подготовку тестовых данных, включая типы, источники и риски при работе с ними.

Как LLM помогают решать задачи QA-команд

Современные языковые модели эффективно применяются на всех этапах жизненного цикла тестирования.

Оптимизация тестовой базы

Интеллектуальная генерация — создание новых тестовых сценариев на основе пользовательских историй и спецификаций

Выявление дубликатов — анализ существующих тест-кейсов для поддержания чистоты и управляемости базы

Умная приоритизация — определение критичных тестов для быстрого запуска на основе анализа изменений и истории

Автоматизация ежедневных задач

Умный поиск по документации — мгновенный доступ к нужной информации в спецификациях и требованиях

Рефакторинг автотестов — поддержка единого стиля кода и улучшение читаемости через IDE-плагины

Управление метаданными — автоматическое обновление тегов, приоритетов и компонентов при изменении функциональности

Такой подход позволяет QA-специалистам сосредоточиться на задачах, требующих человеческой экспертизы, в то время как AI берет на себя рутинную работу.

📌 Читайте также

Что такое тестовые данные и зачем их готовить — разбираем подготовку тестовых данных, включая типы, источники и риски при работе с ними.

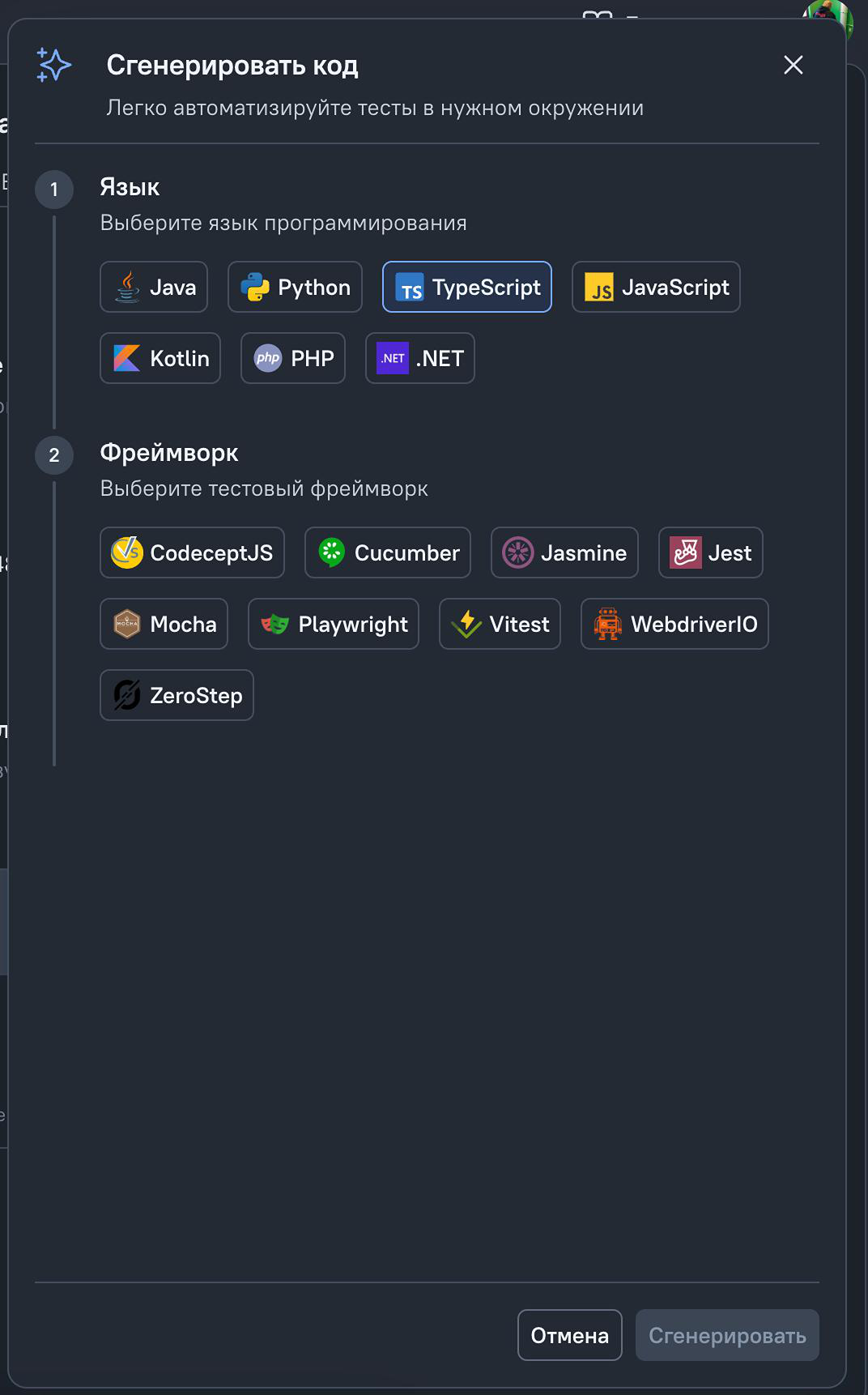

Кодогенерация в ТестОпс и интеграция с AI-фреймворками

TMS ТестОпс предоставляет инструменты для эффективного управления автоматизацией тестирования через интеграцию с AI-фреймворком ZeroStep. Рассмотрим, как это работает на практике.

Принцип работы кодогенерации

В традиционных фреймворках автоматизации тестировщику необходимо писать код, явно указывая селекторы элементов и программируя каждое действие. ТестОпс упрощает этот процесс:

Шаблоны и конфигурации — система позволяет создавать готовые шаблоны тест-кейсов на основе обработки естесственного языка.

Преобразование описаний — человеческие формулировки действий («нажать кнопку», «закрыть окно») преобразуются в код

Интеграция с ZeroStep — сгенерированный код передается в AI-фреймворк ZeroStep для дальнейшей обработки

Как работает связка ТестОпс + ZeroStep

TMS ТестОпс действует как конвертер: преобразует описания тестовых шагов в формат, понятный AI-фреймворку, используя заранее настроенные шаблоны.

Фреймворк ZeroStep анализирует полученные команды и самостоятельно находит нужные элементы интерфейса, используя заготовленные решения для программного кода.

💡 Пример случая применения кодогенерации в ТестОпс с ZeroStep

Тестировщик пишет шаг «закрыть окно подтверждения»;

ТестОпс конвертирует это в структурированный запрос для ZeroStep;

ZeroStep с помощью AI находит нужный элемент на странице и выполняет действие.

ВАЖНО! После выбора языка программирования (например, TypeScript) в интерфейсе появляется возможность выбрать фреймворк ZeroStep для дальнейшей генерации кода.

Преимущества экосистемного подхода и автоматизации

Упрощение автоматизации — тестировщики могут создавать автотесты, фокусируясь на логике, а не на технических деталях

Гибкость настройки — поддержка разных языков программирования и фреймворков через систему шаблонов

Интеграция с AI — возможность использовать преимущества искусственного интеллекта через такие инструменты как ZeroStep

Переиспользование кода — готовые конфигурации можно применять к разным тест-кейсам

Такой подход демонстрирует, как традиционные инструменты тестирования могут эффективно взаимодействовать с AI-решениями, расширяя возможности команды QA.

📚 Попробуйте в работе

Узнайте подробнее о возможностях интеграции ТестОпс с различными фреймворками автоматизации. Чтобы начать пробное использование, свяжитесь с нами по электронной почте [email protected].

Итоги и перспективы

Большие языковые модели уже активно применяются в автоматизации тестирования ПО, помогая сокращать время выполнения регрессий и обеспечивать более полное покрытие критических сценариев. С дальнейшей эволюцией AI-агентов и их интеграцией с инструментами разработки и управления, такими как IDE‑плагин и Jira, растёт потенциал повышения эффективности всей QA-инфраструктуры.

Однако важно понимать, что ИИ — не замена человеческому опыту, таланту и инженерному мышлению. Например, оценка UX‑дефектов или интерпретация противоречивых бизнес‑требований всё ещё требуют человеческого взгляда и контекстуального понимания, недоступных машинным алгоритмам. Базовая задача «умных инструментов» — расширять возможности специалистов, предоставляя им доступ к мощным инструментам анализа и генерации, снижая рутинную нагрузку и ускоряя принятие решений.

В условиях постоянного усложнения программных систем языковые модели становятся катализатором повышения качества, сохраняя фокус на главной цели — создании надёжного, стабильного и своевременно выпущенного программного продукта.

📢 Подписывайтесь на наш Telegram-канал – новости, релизы и полезные материалы для QA-инженеров.