Сравнение запусков

Вы можете сравнить несколько запусков друг с другом, чтобы понять, как меняется качество проекта со временем. Также это удобный способ посмотреть, какие тесты стабильны, а у каких результат меняется от запуска к запуску.

Выбор запусков для сравнения

Чтобы сравнить запуски:

- Перейдите в раздел Запуски.

- Выберите запуски из списка, установив галочки рядом с ними.

- В нижней части экрана нажмите Сравнить.

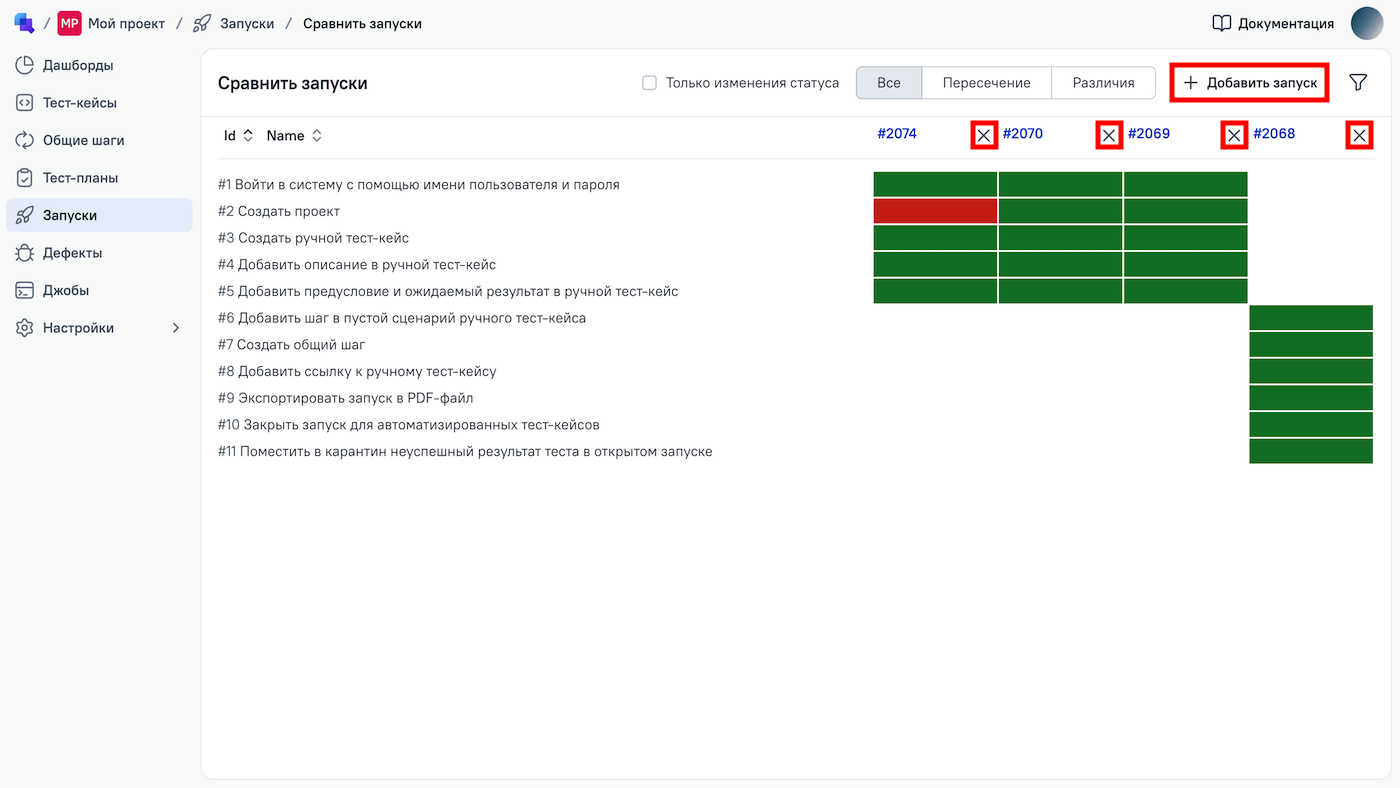

На странице сравнения будет показана таблица, где:

- запуски — столбцы таблицы;

- тест-кейсы, входящие в запуски, — строки таблицы;

- результаты тестов — ячейки таблицы.

Например, если тест-кейс во время запуска был пройден успешно, ячейка будет зеленой, а при неудачном прохождении — красной. Если тест-кейс не является частью определенного запуска, ячейка будет белой (результат отсутствует).

Вы можете изменять ранее созданную таблицу:

- Чтобы добавить запуск к сравнению, нажмите + Добавить запуск в правом верхнем углу.

- Чтобы удалить запуск из сравнения, нажмите на крестик рядом с номером запуска.

Фильтрация тестов при сравнении

Существует несколько способов уменьшить количество тест-кейсов, отображаемых при сравнении запусков:

- Поставьте галочку для варианта Только изменения статуса, чтобы отображались только тест-кейсы, у которых изменился результат выполнения при последующем запуске.

- Выберите режим Пересечение, чтобы отображались тест-кейсы, которые есть во всех сравниваемых запусках. Или выберите режим Различия, чтобы увидеть тест-кейсы, которые отсутствуют хотя бы в одном запуске.

- Нажмите Открыть фильтры в правом верхнем углу, чтобы отфильтровать тест-кейсы по их атрибутам (по владельцу, результату теста, кастомным полям и т. д.). Нажмите Закрыть фильтры, чтобы сбросить и скрыть эти фильтры.